ИИ-мошенничество достигло критических масштабов по всему миру. Злоумышленники активно используют технологии искусственного интеллекта для создания убедительных копий голосов и видеоизображений, обманывая граждан и компании. По данным международных экспертов по кибербезопасности, количество инцидентов с дипфейками выросло на 500% в 2025 году по сравнению с предыдущим годом.

Современные системы клонирования голоса требуют всего 3-15 секунд аудиозаписи для создания реалистичной копии. Мошенники собирают голосовые данные из социальных сетей, мессенджеров и даже случайных видеозвонков, чтобы затем использовать их для обмана жертв. Исследование McAfee показало, что каждый четвертый взрослый столкнулся с клонирование голоса или знает кого-то, кто пострадал от таких атак.

Масштаб угрозы ИИ-мошенничества в мире

Первый квартал 2025 года зафиксировал 179 инцидентов с дипфейками — это на 19% больше, чем за весь 2024 год. Финансовые потери от дипфейк-мошенничества достигли $897 миллионов нарастающим итогом, причем $410 миллионов из них пришлись только на первую половину 2025 года.

По данным отчета Feedzai 2025 года, более 50% случаев мошенничества в финансовом секторе связаны с использованием искусственного интеллекта. Компания Pindrop зафиксировала рост активности дипфейков на 680% по сравнению с предыдущим годом, анализируя более 1,2 миллиарда звонков. Эксперты прогнозируют дальнейший рост дипфейк-мошенничества на 162% к концу 2025 года.

Особенно тревожит тот факт, что в страховом секторе количество случаев синтетического голосового мошенничества выросло на 475%. Каждый 127-й звонок в розничные колл-центры оказывается мошенническим. При этом менее 5% средств, украденных с помощью изощренных схем клонирования голоса, удается вернуть.

Как работают дипфейки и технологии клонирования голоса

Дипфейки — это синтетические медиафайлы, созданные с помощью искусственного интеллекта. Технология позволяет заменять лица и голоса в видео, создавая практически неотличимые от оригинала подделки. В 2025 году количество дипфейк-файлов выросло с 500 тысяч в 2023 году до 8 миллионов.

Методы сбора данных для клонирования голоса включают:

Метод «Проверка безопасности» — мошенники представляются службой безопасности банка и просят произнести определённые фразы для верификации.

Метод «Случайная отправка» — в мессенджерах приходит голосовое сообщение с просьбой переслать его своим голосом, что даёт материал для создания голосовой модели.

Метод «Видеозвонок-ловушка» — неожиданный видеозвонок заставляет ответить «Алло?», и этих секунд достаточно для записи голоса.

Сбор данных из социальных сетей — 53% людей делятся своими голосовыми записями онлайн, что делает их легкой мишенью для злоумышленников.

Громкие случаи ИИ-мошенничества

В 2019 году произошел один из первых зафиксированных случаев ИИ-мошенничества с клонированием голоса: мошенники использовали ИИ для имитации голоса немецкого энергетического руководителя и обманули главу британской дочерней компании на €220,000.

В 2020 году менеджер банка в ОАЭ перевел $35 миллионов после звонка, который, как он считал, поступил от директора головного офиса. Расследование позднее установило, что преступники использовали технологию клонирования голоса в сочетании с поддельными электронными письмами.

В первом квартале 2025 года инциденты с дипфейками, связанные с криптовалютой, включая фальшивые видео с участием знаменитостей вроде Илона Маска, привели к потерям более $200 миллионов.

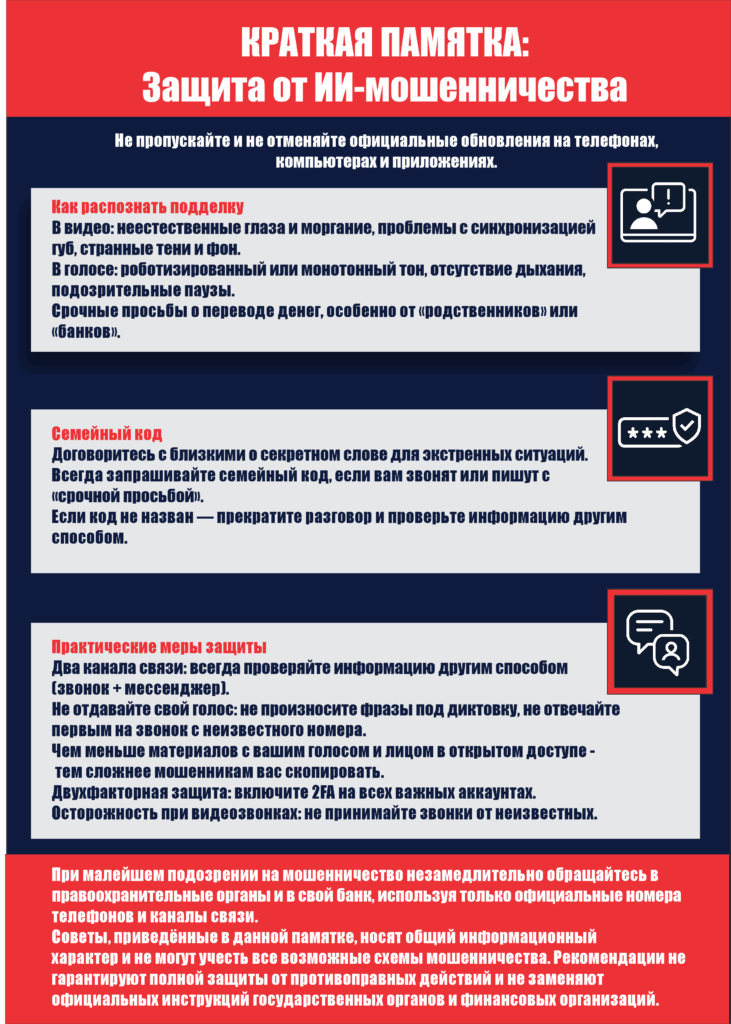

Признаки ИИ-мошенничества: как распознать дипфейки

Эксперты по цифровой безопасности рекомендуют обращать внимание на следующие признаки подделки:

Визуальные несоответствия в видео: неестественное моргание или движения глаз, несоответствие теней и освещения, проблемы с синхронизацией губ и речи, излишняя гладкость кожи, артефакты по контурам фигуры, странное поведение волос или аксессуаров.

Аудио-индикаторы: роботизированный или монотонный тон голоса, неестественные паузы или отсутствие дыхания, странные фоновые шумы или их полное отсутствие, задержки в ответах или несоответствие контексту беседы.

Практические меры защиты от ИИ-мошенничества

Специалисты по кибербезопасности рекомендуют следующие стратегии защиты:

Семейный протокол безопасности — установите кодовое слово для экстренных ситуаций, которое невозможно найти в социальных сетях. Национальная ассоциация кибербезопасности запустила специальную кампанию SafeWord в октябре 2025 года, призывающую семьи внедрить эту практику.

Правило двух каналов связи — получив подозрительный запрос по телефону, проверьте информацию через мессенджер, и наоборот. Эта простая мера предотвращает большинство случаев ИИ-мошенничества.

Защита голосовых данных — не отвечайте на видеозвонки от неизвестных номеров, не произносите фразы под диктовку незнакомцев, молчите первыми при звонке с незнакомого номера, ограничьте публикацию аудио и видео в социальных сетях.

Многофакторная аутентификация — обязательно включите двухфакторную проверку на всех важных аккаунтах. Однако стоит отметить, что исследование Pindrop показало: 53% мошенников успешно проходят проверку на основе контрольных вопросов, а каждый четвертый обходит одноразовые пароли.

Роль искусственного интеллекта в борьбе с киберугрозами

Парадоксально, но искусственный интеллект становится не только инструментом мошенников, но и средством защиты. По данным отчета Feedzai, 90% финансовых учреждений используют ИИ для ускорения расследований мошенничества и обнаружения новых тактик в реальном времени. Две трети банков интегрировали ИИ-решения в свои системы защиты за последние два года.

Современные технологии кибербезопасности используют машинное обучение для обнаружения аномалий, анализа миллионов событий в секунду и выявления подозрительного поведения. Однако банки сталкиваются с серьезными препятствиями при внедрении, особенно в обеспечении этичности и прозрачности технологий, в то время как преступники используют ИИ без таких ограничений.

Статистика по категориям дипфейк-атак

Анализ инцидентов с дипфейками с 2017 года показывает следующее распределение:

Мошенничество составляет 31% всех инцидентов, из них 17% затрагивают политических деятелей, 27% — знаменитостей, и 56% — другие виды мошенничества.

Явный контент составляет 25% инцидентов, при этом 35% нацелены на политиков или знаменитостей, и 65% — на обычных граждан.

Политически заряженный контент представляет 27% случаев.

Прочие инциденты составляют 17%.

В первом квартале 2025 года знаменитости стали объектами атак 47 раз — это рост на 81% по сравнению со всем 2024 годом. Политики были атакованы 56 раз, почти достигнув показателя 2024 года (62 случая).

Что делать при столкновении с ИИ-мошенничеством

Если вы подозреваете, что стали жертвой:

Немедленно заблокируйте банковские карты, позвонив в банк с официального номера. Смените пароли на всех аккаунтах, начиная с самых важных. Обратитесь в правоохранительные органы и подайте заявление в полицию. Предупредите близких о возможном использовании ваших данных для мошенничества. Сохраните все доказательства — скриншоты, записи звонков, логи переписок для расследования.

Международный ответ на угрозу

В 2024 году Европол сообщил о перехвате более 7,500 мошеннических звонков в рамках международной операции, предотвратив потенциальные финансовые потери на сумму свыше €10 миллионов более чем в 80% случаев.

ФБР США выпустило предупреждение в 2025 году о том, что неустановленные «злонамеренные субъекты» выдают себя за высокопоставленных американских чиновников. В Европейском Союзе мошенники выдавали себя за агентов Европола.

В Нидерландах количество попыток голосового фишинга утроилось в 2024 году. В Великобритании более трети (35%) предприятий сообщили, что стали объектами мошенничества в первом квартале 2025 года по сравнению с 23% в предыдущем году.

Будущее противодействия ИИ-мошенничеству

Эксперты прогнозируют появление новых технологий защиты: системы автоматического обнаружения дипфейков, блокчейн-верификация подлинности медиафайлов, ИИ-детекторы синтезированной речи, биометрическая аутентификация на основе уникальных физических характеристик.

Рынок технологий обнаружения дипфейков переживает бум. Итальянский стартап Trustfull привлек 6 миллионов евро в июле 2025 года для укрепления защиты от дипфейк-мошенничества и масштабных фишинговых кампаний. Компания OpenAI усилила защиту своего инструмента генерации видео Sora 2 после давления со стороны актера Брайана Крэнстона и ряда голливудских ассоциаций.

Образование как ключ к цифровой безопасности

Специалисты подчеркивают: главным барьером против ИИ-мошенничества остается информированность пользователей. Исследование McAfee показало, что 70% людей не уверены в своей способности отличить клонированный голос от настоящего.

Необходимо помнить три ключевых принципа: проверяйте информацию через разные каналы, замедляйтесь — срочность всегда подозрительна, обучайте — делитесь знаниями о киберугрозах с близкими, особенно с представителями старшего поколения.

По прогнозам Deloitte Center for Financial Services, генеративные преступления только в США может достичь $40 миллиардов к 2027 году. Глобальные потери от таких правонарушений в 2024 году составили $1 триллион. Эти цифры подчеркивают критическую важность повышения осведомленности о цифровой безопасности на всех уровнях.

Вам также может быть интересно:

- Кибербезопасность в 2025 году: как защитить свои данные

- Кибербезопасность и роль медиа в цифровую эпоху

- CAMIA: новый метод атак раскрывает, что ИИ запоминает о ваших данных

Источники:

- Feedzai — 2025 AI Trends in Fraud and Financial Crime Prevention

- Pindrop — Deepfake Fraud Could Surge 162% in 2025

- Surfshark Research — Deepfake Statistics 2025

Примечание:

Настоящий материал подготовлен на основании информации, размещённой в открытых источниках, и носит исключительно информационно-справочный характер. Представленные сведения не являются официальным заключением и не могут рассматриваться в качестве юридической, финансовой или иной профессиональной консультации. Публикация не имеет рекламного характера. Упоминание торговых марок, брендов и наименований организаций носит исключительно информационный характер и не подразумевает их продвижение или одобрение.

Полезная информация, много что узнал